ChatGPT Enterprise는 AI 혁신을 주도하고 있습니다.

직원 생산성 향상에 이메일만큼 중요한 역할을 하지만 잘못 사용하면 회사를 위험에 빠뜨릴 수도 있습니다.

ChatGPT 데이터 보안을 통해 AI 혁신을 보호하세요

Forcepoint를 사용하면 조직이 데이터와 ChatGPT에 대한 종합적 가시성과 제어를 확보하여,

위험을 초래하지 않고 이점을 극대화할 수 있습니다.

위험 발견

민감한 정보 및 그 사용량에 대한

완전한 가시성을 확보하세요.

데이터 제어

사용자가 ChatGPT에 개인정보를

제공하지 못하도록 차단하세요.

오용 방지

어디에서든 액세스를 관리하고

보안 정책을 시행하세요.

AI의 강력한 성능을 안전하게 활용하세요

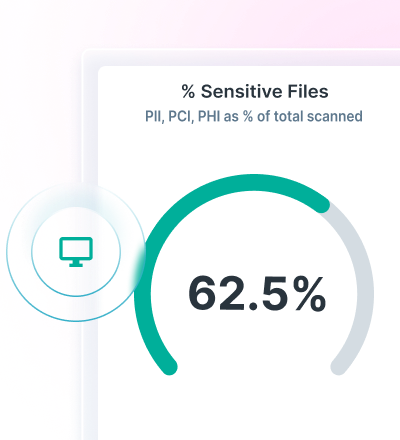

Data Security Posture Management(DSPM)를 통해 데이터 검색 및 분류에 대한 가시성을 확보하세요.

Forcepoint Data Loss Prevention을 통해 ChatGPT에 DLP 정책을 적용하고 데이터 손실을 방지하세요.

Forcepoint Security Cloud를 통해 클라우드 및 웹 앱에 대한 액세스를 보호하고 지속적으로 데이터를 제어하세요.

고급 AI 메시 기술을 통한 데이터 탐색 및 보호

Forcepoint DSPM은 최첨단 AI 메시 기술을 기반으로 정확성, 효율성, 신뢰성이 개선된 혁신적인 데이터 분류 기능을 제공합니다.

AI와 데이터 과학 모델 네트워크를 통해 신뢰도 높은 데이터 분류 기능을 초고속으로 제공하므로 모든 데이터를 반영하고 안전하게 보호할 수 있습니다.

Forcepoint DSPM을 통해 ChatGPT Enterprise 사용자 및 사용자가 제출하는 프롬프트, 업로드되는 파일과 해당 파일이 초래하는 위험, 데이터 주권 문제를 확인하고 사용자 인스턴스에서 데이터를 삭제하세요.

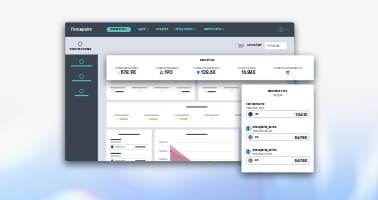

ChatGPT용 DLP를 통한 데이터 손실 방지

즉시 사용 가능한 1,700개 이상의 분류기를 활용하여 데이터 손실을 차단합니다.

민감한 정보를 웹브라우저와 클라우드 앱에 복사하여 붙여넣지 못하도록 차단합니다.

정책 관리를 통합하고 사용자가 데이터에 액세스하는 모든 곳에 정책을 적용합니다.

통합된 정책 관리를 사용하여 생성형 AI를 통한 데이터 손실을 제어합니다.

업계 애널리스트 보고서

Forcepoint Security Cloud으로 액세스 및 데이터 제어

사용자, 그룹, 기타 기준에 따라 ChatGPT에 대한 액세스를 제한합니다.

관리되지 않는 기기에서의 ChatGPT 액세스를 제어합니다.

사용자를 ChatGPT로 안내하고 새로운 생성형 AI 애플리케이션을 사용하지 않도록 유도합니다.