確保 ChatGPT 安全可靠。 確保 AI 轉型安全。

全面掌控 ChatGPT Enterprise 內的敏感資料,並且控制資料使用情況,確保全組織使用敏感資料時安全無虞。

ChatGPT Enterprise 是 AI 轉型的先鋒。

它與電子郵件一樣,都對員工的生產力極為重要,但使用時可能使公司面臨風險。

利用 ChatGPT Data Security 確保 AI 轉型安全

Forcepoint 讓組織全方位掌控資料與 ChatGPT,

在不增加風險的情況下,讓效益發揮得淋漓盡致。

發現風險

全面掌控

敏感資料及其使用情況。

控制資料

防止使用者

向 ChatGPT 透露私人資訊。

防止濫用

隨時隨地管理存取權並施行

安全政策。

發揮 AI 技術的力量。 安全無虞。

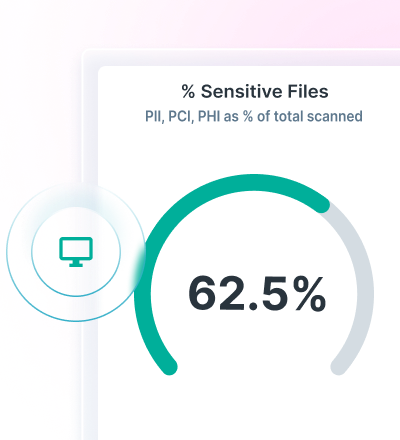

利用 Data Security Posture Management (DSPM),全面掌握資料探索與分類。

利用 Forcepoint Data Loss Prevention,針對 ChatGPT 實施 DLP 政策,防範資料外洩。

利用 Forcepoint Security Cloud 保護雲端與網頁應用程式存取安全,持續控制資料。

利用先進 AI Mesh 技術尋找及保護資料。

Forcepoint DSPM 透過尖端的 AI Mesh 技術,提高準確性、效率和可靠性,提供創新的資料分類方式。

利用 AI 與資料科學模型網路,以超快速度實現高度可信的資料分類,全面掌並確保所有資料安全無虞。

透過 Forcepoint DSPM 全面掌握誰在使用 ChatGPT Enterprise、他們提交的提示內容、正在上傳哪些檔案、該檔案構成哪些風險、任何資料主權問題,以及利用 Forcepoint DSPM 從使用者執行個體刪除資料。

利用 DLP 防範 ChatGPT 的資料外洩

利用 1700 多個隨裝即用的分類器防止資料外洩。

阻擋將敏感資訊複製貼上至網路瀏覽器與雲應用程式。

統一管理政策,並在使用者存取資料的任何位置實施政策。

利用統一的政策管理方式,透過生成式 AI 控制資料外洩。

利用 Forcepoint Security Cloud 控制存取權與資料

根據使用者、群組與其他標準,限制取用 ChatGPT。

控制非託管裝置存取 ChatGPT 的權限。

將使用者導向 ChatGPT,避開新的生成式 AI 應用程式。