تأمين ChatGPT. حماية التحول إلى استخدام الذكاء الاصطناعي.

اكتسب القدرة عل رؤية البيانات الحسّاسة والتحكم في استخدام البيانات في ChatGPT Enterprise لحماية استخدامها عبر المؤسسة.

يحتل ChatGPT Enterprise الصدارة في ما يتعلق بالتحوُّل إلى مجال الذكاء الاصطناعي.

يتمتع هذا البرنامج بأهمية كبيرة في ما يتعلق بإنتاجية القوى العاملة مثل البريد الإلكتروني، لكن قد يؤدي استخدامه إلى تعريض الشركات للخطر.

تؤدي حماية التحوُّل إلى الذكاء الاصطناعي باستخدام برنامج

Forcepoint لأمان بيانات ChatGPT إلى منح المؤسسات رؤية شاملة وتحكمًا في البيانات وChatGPT

حتى يمكنك زيادة مزاياه من دون إدخال المخاطر.

الكشف عن المخاطر

احصل على رؤية كاملة

لبياناتك الحساسة واستخداماتها.

التحكم في البيانات

إيقاف المستخدمين عن مشاركة

المعلومات الخاصة مع ChatGPT.

منع إساءة الاستخدام

إدارة الوصول وتطبيق

سياسات الأمان في أي مكان.

أطلق العنان لقوة الذكاء الاصطناعي. الأمان.

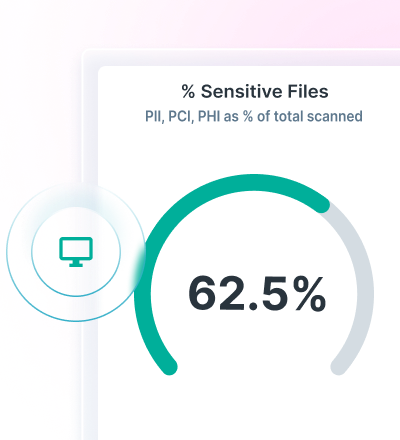

استفد من رؤية واضحة للبيانات من خلال الاكتشاف والتصنيف مع خدمة Data Security Posture Management (DSPM).

تطبيق سياسات DLP الخاصة بالذكاء الاصطناعي التوليدي ومنع فقدان البيانات مع خدمة Forcepoint Data Loss Prevention.

تأمين الوصول إلى تطبيقات الخدمة السحابية والويب والحصول على التحكم المستمر في البيانات مع Forcepoint Security Cloud.

العثور على البيانات وتأمينها باستخدام Advanced AI Mesh Technology

توفر Forcepoint DSPM تصنيفًا مبتكرًا للبيانات من خلال تحسين الدقة والكفاءة والموثوقية من خلال تقنية AI Mesh المتقدمة.

يتيح استخدام شبكة من نماذج الذكاء الاصطناعي وعلوم البيانات تصنيف البيانات بثقة عالية بسرعة فائقة لضمان تضمين جميع بياناتك وتأمينها.

يمكنك معرفة من يستخدم شركة الذكاء الاصطناعي ChatGPT وما المطالبات التي يرسلها، وأي الملفات التي يجري تحميلها، وما المخاطر التي تنجم عن تلك الملفات، وأي مشكلات تتعلق بالقوانين التي تحكم تلك البيانات، وحذف البيانات من مثيلات المستخدم باستخدام خدمة Forcepoint DSPM.

منع فقدان البيانات باستخدام DLP لروبوت ChatGPT

الاستفادة من أكثر من 1700 أداة تصنيف فريدة لإيقاف فقدان البيانات.

احظر نسخ البيانات الحساسة ولصقها في متصفحات الويب وتطبيقات السحابة.

قم بتوحيد إدارة السياسات وتطبيقها في كل مكان يمكن للمستخدمين الوصول إلى البيانات منه.

استخدم إدارة السياسة الموحدة للتحكم في فقدان البيانات من خلال الذكاء الاصطناعي التوليدي.

INDUSTRY ANALYST REPORT

التحكم في الوصول والبيانات باستخدام Forcepoint Security Cloud

قم بتقييد الوصول إلى ChatGPT استنادًا إلى المستخدمين والمجموعات وغيرها من المعايير .

تحكم في الوصول إلى ChatGPT على الأجهزة غير المُدارة.

وجِّه المستخدمين إلى ChatGPT وابتعد عن تطبيقات الذكاء الاصطناعي التوليدي الجديدة.

تحسين أمان بيانات ChatGPT من خلال Forcepoint