ChatGPT Enterprise está a la vanguardia de la transformación de la IA.

Es tan esencial para la productividad de la fuerza laboral como el correo electrónico, pero su uso podría poner en riesgo a las empresas.

Protege la transformación de la IA con ChatGPT Data Security

Forcepoint ofrece a las organizaciones visibilidad y control integrales de los datos y ChatGPT,

para que puedas maximizar sus beneficios sin introducir riesgos.

Descubre el riesgo

Obtén visibilidad total de tus datos

confidenciales y su uso.

Controla los datos

Impide que los usuarios compartan

información privada con ChatGPT.

Evita el uso indebido

Gestiona el acceso y aplica políticas

de seguridad en cualquier lugar.

Libera el poder de la IA. De forma segura.

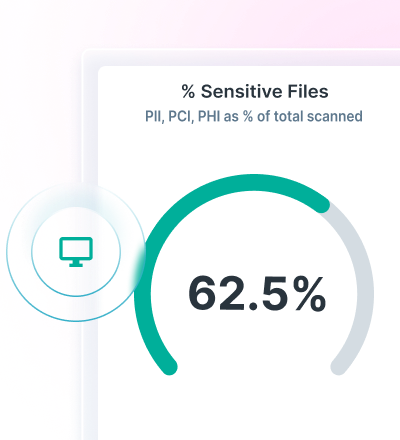

Obtén visibilidad del descubrimiento y la clasificación de datos con Data Security Posture Management (DSPM).

Aplica políticas de DLP para la IA generativa y evita la pérdida de datos con Forcepoint Data Loss Prevention.

Protege el acceso a aplicaciones web y en la nube, y obtén un control continuo de los datos con el Forcepoint Security Cloud.

Encuentra y protege los datos con la tecnología avanzada de AI Mesh

Forcepoint DSPM ofrece una clasificación de datos innovadora mediante su optimización de la precisión, eficiencia y fiabilidad a través de su tecnología de AI Mesh de vanguardia.

El uso de una red de modelos de IA y ciencia de datos permite una clasificación de datos de gran confianza a grandes velocidades, para garantizar que todos tus datos se contabilicen y estén seguros

Consulta quién está utilizando la IA generativa, qué solicitudes envían, qué archivos se están cargando, qué riesgo plantean esos archivos y cualquier problema de soberanía de datos, y elimina datos de instancias de usuarios con Forcepoint DSPM.

Evita la pérdida de datos con DLP para ChatGPT

Utiliza más de 1700 clasificadores listos para implementar para detener la pérdida de datos.

Bloquea, copia y pega información confidencial en navegadores web y aplicaciones en la nube.

Unifica la administración de políticas y aplícalas en cualquier lugar donde los usuarios accedan a los datos.

Utiliza la administración de políticas unificada para controlar la pérdida de datos por medio de la IA generativa.

INFORME ANALÍTICO DE LA INDUSTRIA

Controla el acceso y los datos con Forcepoint Security Cloud

Limita el acceso a ChatGPT en función de los usuarios, los grupos y otros criterios.

Controla el acceso a ChatGPT en dispositivos no administrados.

Dirige a los usuarios a ChatGPT y aléjalos de nuevas aplicaciones de GenAI.

Mejora la seguridad de los datos de ChatGPT con Forcepoint