O ChatGPT Enterprise está na vanguarda da transformação da IA.

É tão essencial para a produtividade da força de trabalho quanto o e-mail, mas seu uso pode colocar as empresas em risco.

Proteja a transformação da IA com o ChatGPT Data Security

A Forcepoint oferece às organizações visibilidade e controle abrangentes sobre os dados e o ChatGPT,

para que você possa maximizar seus benefícios sem criar riscos.

Descubra o risco

Tenha total visibilidade dos seus

dados confidenciais e seu uso.

Controle de Dados

Impeça os usuários de compartilhar

informações privadas com o ChatGPT.

Evite o uso indevido

Gerencie o acesso e aplique

políticas de segurança em qualquer lugar.

Libere o poder da IA. Com segurança.

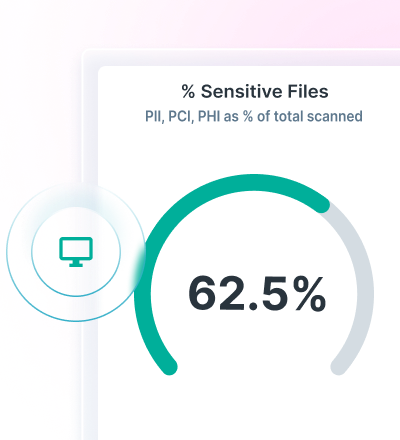

Tenha a visibilidade da descoberta e classificação de dados com o Data Security Posture Management (DSPM).

Imponha políticas de DLP para o ChatGPT e evite a perda de dados com o Forcepoint Data Loss Prevention.

Proteja o acesso a aplicativos em nuvem e na web, além de controle contínuo sobre os dados com o Forcepoint Security Cloud.

Encontre e proteja dados com a tecnologia Advanced AI Mesh

O Forcepoint DSPM oferece classificação de dados inovadora, melhorando a precisão, a eficiência e a confiabilidade por meio de sua tecnologia AI Mesh de ponta.

O uso de uma rede de modelos de IA e ciência de dados permite a classificação de dados altamente confiável em velocidades extremamente rápidas para garantir que todos os seus dados sejam contabilizados e seguros.

Veja quem está usando o ChatGPT Enterprise, quais comandos eles enviam, quais arquivos estão sendo carregados, qual o risco que esses arquivos representam, quaisquer problemas de soberania de dados e exclua dados de instâncias de usuários com o Forcepoint DSPM.

Evite a perda de dados com o DLP para ChatGPT

Utilize mais de 1.700 classificadores out-of-the-box para impedir a perda de dados.

Bloqueie a cópia e a colagem de informações confidenciais em navegadores da web e aplicativos em nuvem.

Unifique o gerenciamento de políticas e imponha-as em todos os lugares em que os usuários acessam dados.

Utilize a administração unificada de políticas para controlar a perda de dados por meio de IA generativa.

RELATÓRIO DE ANALISTA DO SETOR

Controle o acesso e os dados com o Forcepoint Security Cloud

Limite o acesso ao ChatGPT com base em usuários, grupos e outros critérios.

Controle o acesso ao ChatGPT em dispositivos não gerenciados.

Direcione os usuários para o ChatGPT e para longe de novos aplicativos de GenAI.

Melhore a segurança de dados no ChatGPT com a Forcepoint