ChatGPT Enterprise est à l'avant-garde de la transformation de l'IA.

Il est aussi essentiel à la productivité de la main-d'œuvre que le courrier électronique, mais son utilisation pourrait mettre les entreprises en danger.

Sauvegardez la transformation de l'IA avec ChatGPT Data Security

Forcepoint offre aux entreprises une visibilité et un contrôle complets sur les données et ChatGPT,

afin que vous puissiez maximiser ses avantages sans introduire de risque.

Découvrez les risques

Obtenez une visibilité totale sur vos

données sensibles et leur utilisation.

Contrôler les données

Empêchez les utilisateurs de partager des

informations privées avec ChatGPT.

Prévenez les abus

Gérez l’accès et appliquez des politiques de

sécurité n’importe où.

Libérez la puissance de l’IA. En toute sécurité.

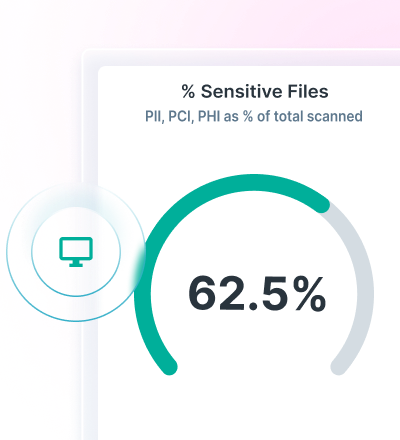

Obtenez de la visibilité avec la découverte et la classification des données grâce à Data Security Posture Management (DSPM).

Appliquez les politiques DLP pour ChatGPT et empêchez la perte de données avec Forcepoint Data Loss Prevention.

Sécurisez l’accès aux applications cloud et Web et maîtrisez en permanence les données avec Forcepoint Security Cloud.

Trouvez et sécurisez les données avec la technologie avancée AiMesh

Forcepoint DSPM offre une classification des données innovante en améliorant la précision, l'efficacité et la fiabilité grâce à sa technologie AiMesh de pointe.

L’utilisation d’un réseau de modèles d’IA et de science des données permet une classification très sûre de ces données, et ce à des vitesses extrêmement rapides, afin de garantir que toutes vos données sont comptabilisées et sécurisées.

Découvrez qui utilise ChatGPT Enterprise, les invites qui sont soumises, les fichiers qui sont téléchargés, les risques que ces fichiers présentent, les problèmes de souveraineté des données ; supprimez les données des instances utilisateur avec Forcepoint DSPM.

Prévenez la perte de données avec DLP pour ChatGPT

Utilisez plus de 1 700 classificateurs prêts à l’emploi pour stopper la perte de données.

Bloquez le copier-coller des informations sensibles dans les navigateurs Web et les applications cloud.

Unifiez la gestion des politiques et faites-les respecter partout où les utilisateurs accèdent à des données.

Utilisez une gestion unifiée des politiques pour limiter les pertes de données dues aux IA génératives.

RAPPORT SUR LES ANALYSTES DE L'INDUSTRIE

Maîtrisez l’accès et les données avec Forcepoint Security Cloud

Limitez l'accès à ChatGPT en fonction des utilisateurs, des groupes et d'autres critères.

Contrôlez l'accès à ChatGPT sur des appareils non gérés.

Dirigez les utilisateurs vers ChatGPT et loin des nouvelles applications GenAI.

Améliorez la sécurité des données ChatGPT avec Forcepoint