ChatGPT Enterprise 处于人工智能转型的最前沿。

它对员工生产力来说和电子邮件一样重要,但使用它可能会使公司面临风险。

借助 ChatGPT 数据安全

Forcepoint 保障 AI 转型,会给组织带来全面可见性和对数据及 ChatGPT

的控制,让您可以最大化其优势,而不会引入风险。

揭露风险

全面掌握您的

敏感数据及其使用情况。

控制数据

阻止用户与 ChatGPT 共享

私人信息。

防止滥用

随处管理访问并强制执行

安全策略。

释放人工智能的力量。 安全地。

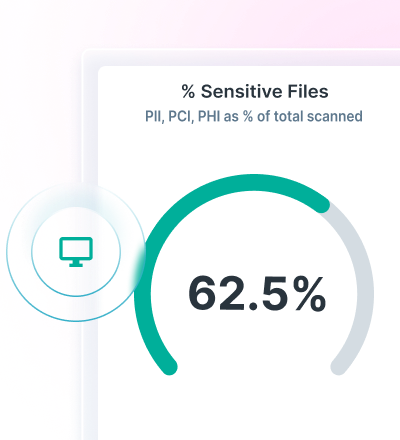

利用 Data Security Posture Management (DSPM),掌握数据发现和分类的情况。

使用 Forcepoint 数据泄露防护,为 ChatGPT 实施 DLP 策略并防止数据泄露。

使用 Forcepoint Security Cloud,安全访问云和网络应用程序,并获得对数据的持续控制。

使用先进的 AI Mesh 技术

Forcepoint DSPM 找到并保护数据,通过其尖端的 AI Mesh 技术提高准确度、效率和可靠性,实现创新的数据分类。

使用人工智能和数据科学模型的网络,以迅雷之速进行高度可靠的 Data Classification,以确保您的所有数据都被包括且安全无忧。

了解谁在使用 ChatGPT Enterprise、他们提交什么提示、正在上传哪些文件、这些文件构成什么风险、是否有任何数据主权问题,以及使用 Forcepoint DSPM 从用户实例中删除数据。

借助 DLP for ChatGPT,防止数据泄露

利用 1700 多个立即可用的分类器来阻止数据泄露。

阻止敏感信息复制和粘贴到网络浏览器和云应用程序。

统一策略管理,并在用户访问数据的任何地方强制执行。

使用统一策略管理,控制因生成式人工智能导致的数据泄露。

使用 Forcepoint Security Cloud 控制访问和数据

根据用户、群组和其他标准限制对 ChatGPT 的访问。

控制非托管设备上对 ChatGPT 的访问。

引导用户访问 ChatGPT,并远离新的 GenAI 应用程序。