ChatGPT'yi Güvence Altına Alın. Yapay Zeka Dönüşümünü güvence altına alın.

Kuruluş genelinde ChatGPT Kurumsal kullanımını güvence altına almak için hassas verilere dair görünürlük kazanın ve veri kullanımının kontrolünü elinize tutun.

ChatGPT Kurumsal, yapay zeka dönüşümünün ön saflarında yer alıyor.

ChatGPT Kurumsal, yapay zeka ve iş gücü verimliliği açısından e-posta kadar önemlidir, ancak kullanımı şirketleri riske atabilir.

ChatGPT Veri Güvenliği ile Yapay Zeka Dönüşümünü Güvence Altına Alın

Forcepoint, kuruluşlara veriler ve ChatGPT üzerinde kapsamlı görünürlük ve kontrol sağlar;

böylece risk almadan faydalarını en üst düzeye çıkarabilirsiniz.

Riskleri Ortaya Çıkarın

Hassas verilerinize ve kullanımınıza

dair eksiksiz bir görünürlük elde edin.

Verileri Kontrol Edin

Kullanıcıların özel bilgileri

ChatGPT ile paylaşmasının önüne geçin.

Kötüye Kullanımları Önleyin

Erişimi yönetin ve güvenlik politikalarını

her yerde uygulayın.

Yapay Zekanın gücünü açığa çıkarın. Güvenle.

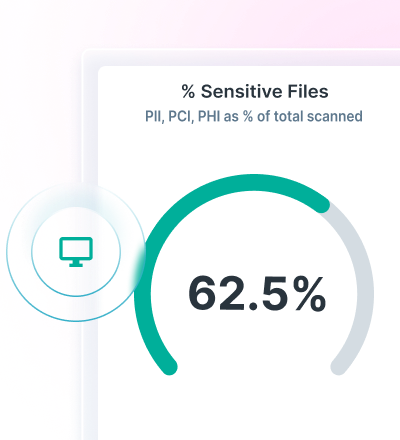

Data Security Posture Management (DSPM) ile veri keşfi ve sınıflandırma konularında görünürlük elde edin.

Üretken Yapay Zeka için DLP politikalarını uygulayın ve Forcepoint Data Loss Prevention ile veri kaybını önleyin.

Forcepoint Security Cloud ile bulut ve web yazılımlarına erişimi güvence altına alın ve veriler üzerinde sürekli kontrol sağlayın.

Gelişmiş AI Mesh Teknolojisiyle Verileri Bulun ve Güvence Altına Alın

Forcepoint DSPM son teknoloji yapay zeka ağ teknolojisiyle doğruluk, verimlilik ve güvenilirliği artırarak yenilikçi veri sınıflandırması sunar.

Yapay zeka ve veri bilimi modellerinden oluşan bir ağ kullanmak, tüm verilerinizin hesaba katılmasını ve güvende olmasını sağlamak için son derece güvenli veri sınıflandırmasını çok hızlı bir şekilde sağlar.

Forcepoint DSPM ile kimlerin kurumsal ChatGPT kullandığını, hangi istemleri gönderdiklerini, hangi dosyaların yüklendiğini, bu dosyaların ne gibi riskler oluşturduğunu, veri sahipliği ile ilgili sorunları görün ve verileri kullanıcı işlemlerinden silin.

ChatGPT için DLP ile Veri Kaybını Önleyin

Veri kaybını durdurmak için 1.700'den fazla kullanıma hazır sınıflandırıcıdan yararlanın.

Hassas bilgilerin web tarayıcılarına ve buluttaki uygulamalara kopyalanmasını ve yapıştırılmasını engelleyin.

Politika yönetimini tek bir çatı altında toplayın ve kullanıcıların verilere eriştiği her yerde bunları uygulayın.

Üretken yapay zekayla veri kaybını kontrol etmek için birleşik politika yönetimini kullanın.

INDUSTRY ANALYST REPORT

Forcepoint Security Cloud ile Erişimi ve Verileri Kontrol Altında Tutun

Kullanıcılar, gruplar ve diğer kriterlere göre ChatGPT’ye erişimi sınırlandırın.

Yönetilmeyen cihazlardaki ChatGPT'ye erişimi kontrol altında tutun.

Kullanıcıları ChatGPT’ye yönlendirin ve yeni üretken yapay zeka uygulamalarından uzaklaştırın.

Forcepoint ile ChatGPT Veri Güvenliğini Geliştirin