ChatGPT Enterpriseは、AI変革の最先端に立っています。

これは電子メールと同様に、職場の生産性に必要不可欠なものですが、その使用により企業が危機に晒される恐れがあります。

ChatGPTデータセキュリティでAI変革の安全性を確保

Forcepointは、組織にデータとChatGPTの包括的な可視性と制御を提供するため、

リスクなしにメリットを最大化することができます。

リスクの明白化

機密データとその使用状況を

完全に可視化します。

データを制御

ユーザーがChatGPTで

個人情報を共有することを阻止します。

悪用を防止

アクセスを管理し、

あらゆる場所にセキュリティポリシーを適用します。

AIの力を解放。安全に。

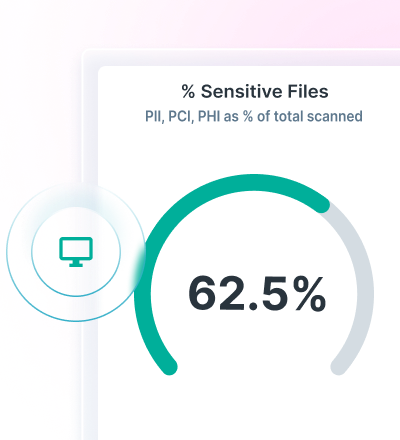

Data Security Posture Management(DSPM)が、 データ検出から分類にいたるまでの過程を可視化します。

Forcepoint Data Loss Preventionが、ジェネレーティブAIにDLPポリシーを適用し、データの損失を防止します。

Forcepoint Security Cloudが、クラウドやWebアプリへのアクセスを保護し、データの継続的な管理を確保します。

高度なAIメッシュテクノロジーによるデータの検出と保護

Forcepoint DSPMは、最先端のAIメッシュテクノロジーにより精度、効率、信頼性を高め、革新的なデータ分類を提供します。

AIとデータサイエンスモデルのネットワークを使用することで、非常に信頼性の高いデータ分類を非常に速いスピードで実現することができ、すべてのデータを考慮した安全性を確保できます。

Forcepoint DSPMを使用すれば、ChatGTP Enterpriseを使用しているユーザー、送信されたプロンプト、アップロードされているファイル、それらのファイルの潜在リスク、データ主権の問題、ユーザーインスタンスから削除されたデータを確認できます。

ChatGPT用DLPでデータ損失を防止

すぐに使える1,700以上の分類子を活用したデータ損失防止。

Webブラウザやクラウドアプリへの機密情報のコピー・ペーストを阻止します。

ポリシー管理を統合し、ユーザーがデータにアクセスするあらゆる場所に適用します。

統合されたポリシー管理を使用して、生成AIを通じてデータ損失を管理します。

INDUSTRY ANALYST REPORT

Forcepoint Security Cloudでアクセスとデータを制御

ユーザー、グループなどの基準に基づき、ChatGPTへのアクセスを制限します。

管理されていないデバイスからのChatGPTへのアクセスを制御します。

ユーザーをChatGPTに誘導し、別の新たな生成AI使用を回避させます。