X-Labs

Get insight, analysis & news straight to your inbox

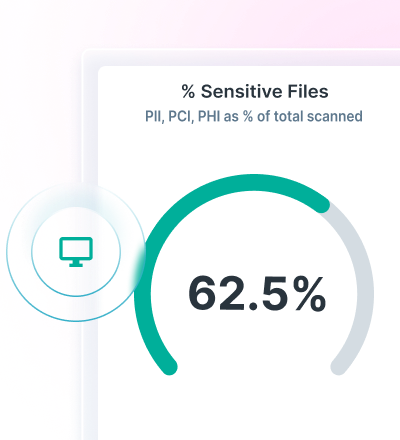

PII Data Classification: Main Data Types and Tools to Catalog Them

December 21, 2025

SQL Data Discovery and Classification for Database Security

Tim Herr

December 20, 2025

6 Best PII Data Discovery Tools to Ensure Compliance

Lionel Menchaca

December 19, 2025

PCI Data Discovery: Strategies and Tools for Compliance

Tim Herr

December 19, 2025

Structured vs. Unstructured Data: Differences, Use Cases and Best Practices

Tim Herr

December 18, 2025

How to Manage GDPR Data Classification for Global Compliance

Tim Herr

December 17, 2025

The 5 Hidden SaaS Data Risks Every CISO Must Address

Neeraj Nayak

December 17, 2025

Structured Data Classification: Top 5 Tools and Best Practices

Lionel Menchaca

December 16, 2025

Go Slow to Go Fast: The New AI Playbook for IT Infrastructure

Jonathan Knepher

December 15, 2025

10 Best DSPM Tools Compared: Comprehensive Guide for CISOs

Lionel Menchaca

December 14, 2025

Selecting the Right DSPM Solution for Cloud Security: A Comprehensive Guide

Tim Herr

December 13, 2025