ChatGPT Enterprise steht an der Spitze der KI-Transformation.

Für die Produktivität der Mitarbeitenden ist ChatGPT ebenso unerlässlich wie E-Mails, aber seine Verwendung könnte Unternehmen einem Risiko aussetzen.

Sichern Sie die KI-Transformation mit ChatGPT Data Security

Forcepoint bietet Unternehmen umfassende Transparenz und Kontrolle über Daten und ChatGPT

, damit Sie die Vorteile maximieren können, ohne Risiken einzugehen.

Risiken aufdecken

Verschaffen Sie sich vollständige Transparenz über Ihre sensiblen Daten und deren Verwendung.

Daten kontrollieren

Verhindern Sie, dass Benutzer

private Informationen mit ChatGPT teilen.

Missbrauch verhindern

Verwalten Sie den Zugriff und setzen Sie

Sicherheitsrichtlinien überall durch.

Entfesseln Sie die Macht der KI. Sicher.

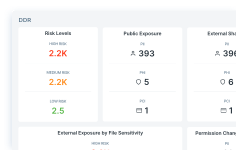

Erhalten Sie mit Data Security Posture Management (DSPM) Transparenz bei der Erkennung und Klassifizierung von Daten.

Setzen Sie DLP-Richtlinien für ChatGPT durch und verhindern Sie Datenverluste mit Forcepoint Data Loss Prevention.

Sichern Sie den Zugriff auf Cloud- und Web-Apps und erhalten Sie mit Forcepoint Security Cloud eine kontinuierliche Kontrolle über Daten.

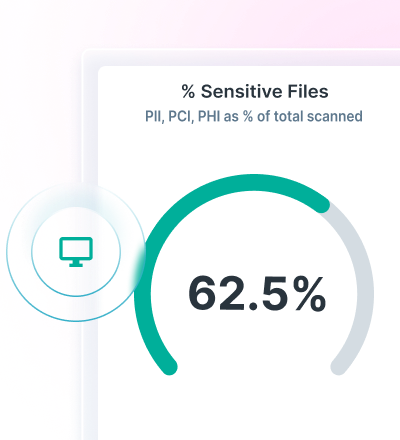

Finden und schützen Sie Daten mit Advanced AI Mesh Technology

Forcepoint DSPM bietet eine innovative Datenklassifizierung, indem es die Genauigkeit, Effizienz und Zuverlässigkeit durch seine hochmoderne KI-Mesh-Technologie verbessert.

Die Verwendung eines Netzwerks von KI- und Data-Science-Modellen ermöglicht eine äußerst zuverlässige Datenklassifizierung bei blitzschneller Geschwindigkeit, um sicherzustellen, dass alle Ihre Daten berücksichtigt werden und sicher sind.

Mit Forcepoint DSPM können Sie sehen, wer ChatGPT Enterprise verwendet, welche Prompts sie übermitteln, welche Dateien hochgeladen werden, welches Risiko diese Dateien darstellen, ob es Probleme mit der Datenhoheit gibt, sowie Daten von Benutzerinstanzen löschen.

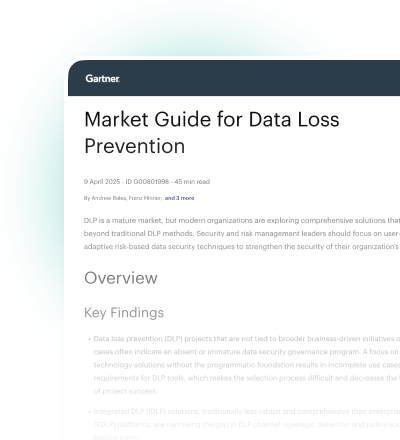

Verhindern Sie Datenverluste mit DLP für ChatGPT

Nutzen Sie mehr als 1.700 standardmäßige Klassifikatoren, um Datenverluste zu verhindern.

Blockieren Sie das Kopieren und Einfügen von sensiblen Informationen in Webbrowser und Cloud-Apps.

Vereinheitlichen Sie die Richtlinienverwaltung und setzen Sie sie überall dort durch, wo Benutzer auf Daten zugreifen.

Verwenden Sie eine einheitliche Richtlinienverwaltung, um Datenverluste durch generative KI zu verhindern.

INDUSTRY ANALYST REPORT

Zugriffs- und Datenkontrolle mit Forcepoint Security Cloud

Beschränken Sie den Zugriff auf ChatGPT basierend auf Benutzern, Gruppen und anderen Kriterien.

Kontrollieren Sie den Zugriff auf ChatGPT auf nicht verwalteten Geräten.

Lenken Sie Benutzer auf ChatGPT um und weg von neuen GenAI-Anwendungen.

Verbessern der ChatGPT-Datensicherheit mit Forcepoint